Resumo

- O estudo da Mercor mostra que agentes de IA, como os da OpenAI e Google, não conseguem realizar mais de 30% das tarefas de profissionais humanos especializados.

- O GPT-5.2 da OpenAI obteve 27,3% de acerto em tarefas de analistas de investimentos, enquanto o Gemini 3 Flash do Google liderou em tarefas de advogados com 25,9%.

- O benchmark APEX-Agents usa prompts de profissionais reais, tornando as tarefas complexas e revelando dificuldades dos agentes em reunir informações de diferentes domínios.

Uma nova pesquisa revelou que agentes de inteligência artificial ainda não conseguem realizar o trabalho de profissionais humanos como consultores de gestão, analistas de investimentos e advogados corporativos. Os modelos disponíveis atualmente não acertam mais do que 30% das tarefas.

O estudo foi realizado pela empresa de recrutamento de profissionais e treinamento de dados Mercor. Seu trabalho resultou em um novo benchmark, chamado AI Productivity Index for Agents, ou APEX-Agents, para simplificar.

Nos testes envolvendo o trabalho de um analista de investimentos, o melhor resultado foi do GPT-5.2, da OpenAI, com 27,3% de acerto. Esse modelo também lidera o ranking de consultoria de gestão, com 22,7% de respostas corretas. E nos testes com tarefas de advogados, o Gemini 3 Flash, do Google, fica no topo, com 25,9%.

Por que os resultados são tão ruins?

Uma das diferenças do APEX-Agents para outros benchmarks é que o teste envolve prompts enviados por profissionais de verdade — e, em grande parte dos casos, os agentes de IA estão trazendo respostas erradas, ou mesmo não trazendo nenhuma resposta.

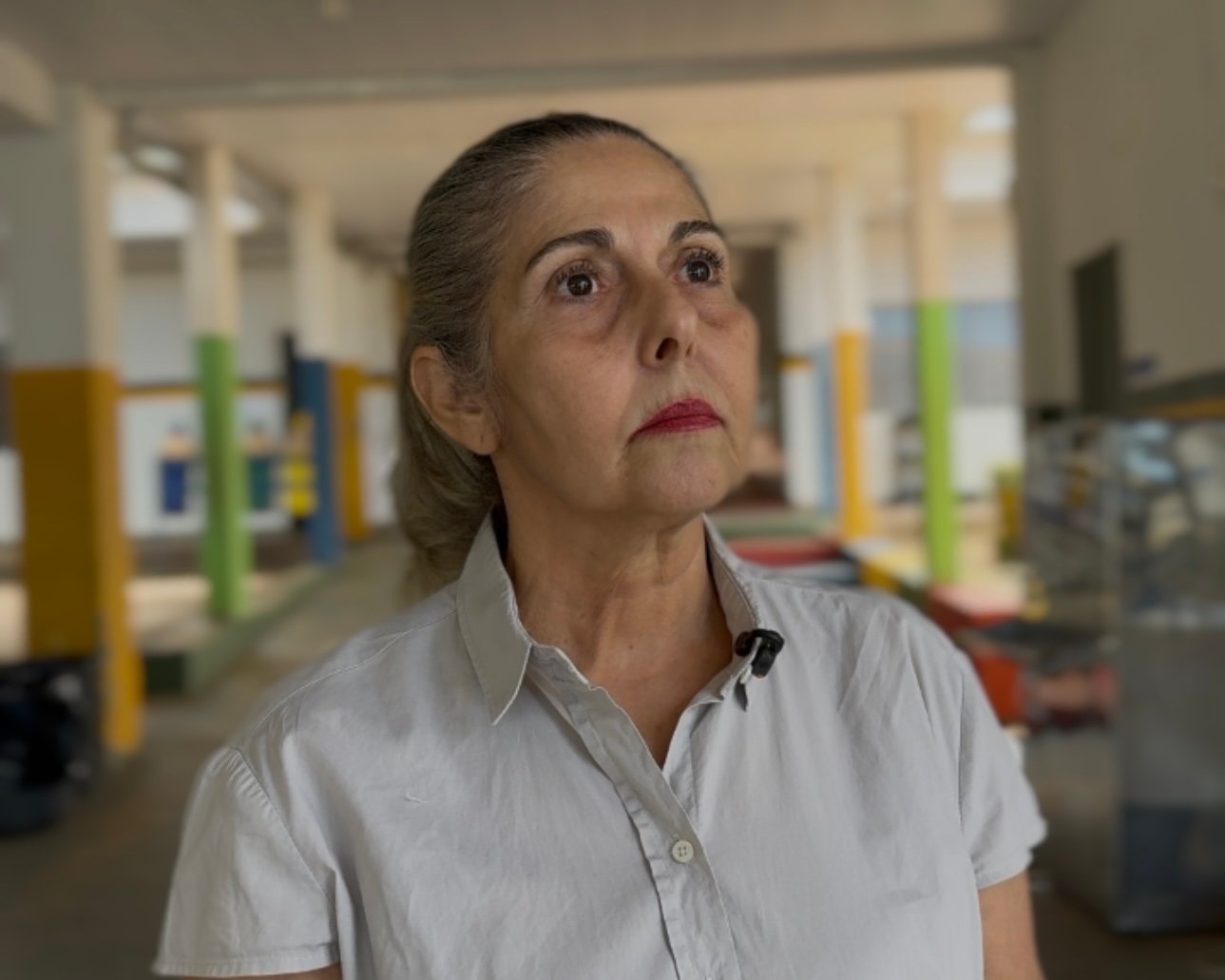

“Uma das grandes mudanças desse benchmark é que nós construímos um ambiente completo, modelado de acordo com serviços profissionais”, explica Brendan Foody, CEO da Mercor e um dos responsáveis pelo estudo.

Essa escolha torna as tarefas muito mais complexas do que as de outros testes, e é aí que mora o problema: os agentes tropeçam na hora de reunir informações que estão espalhadas em diferentes domínios. “Nós trabalhamos sem que alguém nos dê todo o contexto em um único lugar. Na vida real, você opera com o Slack, o Google Drive e todas essas ferramentas”, explica Foody.

Como os agentes de IA foram testados?

As questões do teste foram disponibilizadas publicamente — e são bastante difíceis. Uma delas, por exemplo, envolve analisar um caso em que uma empresa enviou dados pessoais de cidadãos europeus para servidores nos Estados Unidos, considerando as políticas da própria companhia e a legislação de privacidade da União Europeia.

Como observa o TechCrunch, é um trabalho difícil até mesmo para um humano especializado. Os pesquisadores, entretanto, acham que é necessário ver como os agentes de IA se saem em cenários assim, já que isso é o que determinaria se eles são capazes de substituir um trabalhador.

“Acho que esse é o assunto mais importante na economia. O benchmark reflete bem o trabalho real que essas pessoas fazem”, diz o CEO da Mercor.

IA não consegue fazer mais do que 30% do trabalho humano, diz estudo

Clique aqui para acessar a Fonte da Notícia